✔Google рассказал о тонкостях работы со ссылочной массой - «Интернет»

Google более подробно разъяснил вебмастерам «тонкости» работы своей поисковой системы. Представитель компании сообщил, что Googlebot не видит ссылки, которые активируются при наведении курсора. А также о том, что удаление значительной части содержимого файла Disavow не приведет к понижению позиций ресурса в поисковой выдаче.

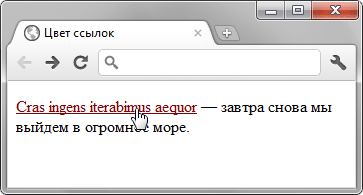

Во время очередной видеоконференции с вебмастерами Джон Мюллер, сотрудник отдела качества поиска компании Google, сообщил, что Googlebot при анализе содержимого сайта не может правильно идентифицировать те ссылки, которые активируются при наведении курсора мыши.

Было отмечено, что ссылки, «спрятанные» от копирования с помощью программного года JQuery, распознаются поисковым роботом так же, как браузером: он их не видит. Это не самый лучший способ защитить ссылки от воровства (автоматического копирования другими ресурсами). Использование jQuery для их «маскировки» может привести к более серьезным проблемам, чем воровство контента, и негативно отразится на позиции ресурса в поисковой выдаче Google.

Также не стоит забывать, что это не единственное известное «ограничение» краулера Google. Напомним, что поисковый робот не может распознавать медленно загружающийся контент на мобильных и «полновесных» версиях сайтов.

Кроме того один из вебмастеров спросил о том, может ли массовое удаление ссылок из файла Disavow (более 1000 URL-адресов и доменов) расцениваться поисковой системой Google как «спамное» действие, если они были ошибочно добавлены более 6 месяцев назад.

В ответ на это было заявлено, что массовое удаление ссылок не приведет к «негативным» воздействиям со стороны поисковой системы.

Редактирование файла приведет лишь к техническим изменениям сайта, поэтому едва ли вызовет «наложение на ресурс ручных санкций».

Вместе с тем было отмечено, что любой вебмастер должен четко понимать, что удаляя ссылки из файла Disavow, он дает понять поисковой системе, какие URL-адреса ей следует учитывать при очередном сканировании ресурса. Негативно повлиять на рейтинг сайта может лишь удаление из этого файла ссылок на «низкокачественные» ресурсы. Поэтому к редактированию содержимого файла Disavow следует относиться весьма серьезно, чтобы собственноручно «не пошатнуть» позиции своего сайта в поисковой выдаче Google.

Также не стоит забывать, что максимальный размер этого файла не может превышать 2 мегабайт. И о том, что функция Disavow Links не действует на все домены, привязанные к определенному IP. Поэтому инструмент отклонит только те входящие ссылки, в href которых прописан адрес веб-страницы, хранящейся на указанном IP.