✔NVIDIA анонсировала Chat with RTX для запуска чат-ботов на основе LLM локально на ПК - «Новости мира Интернет»

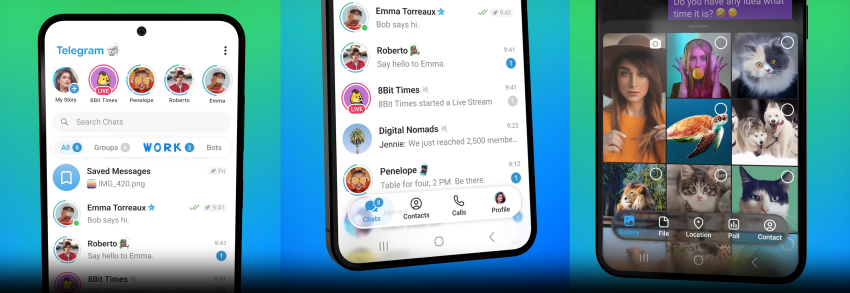

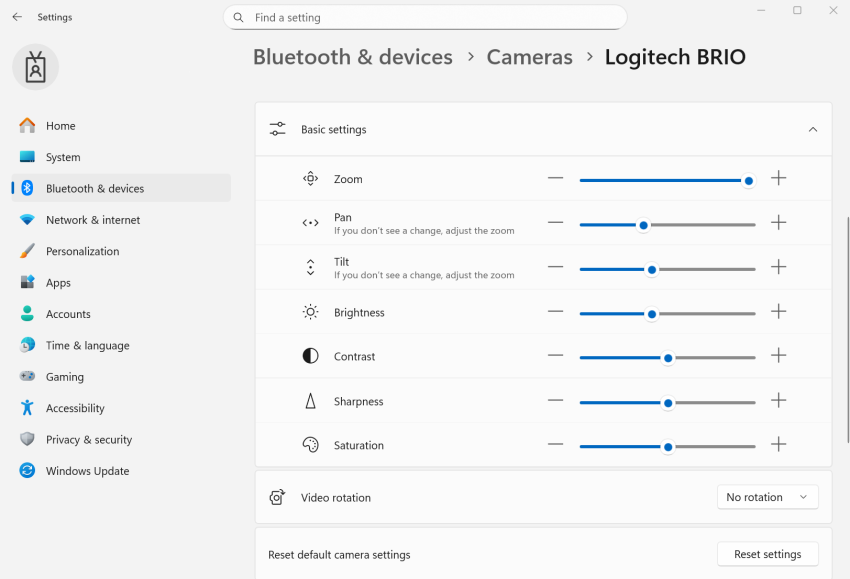

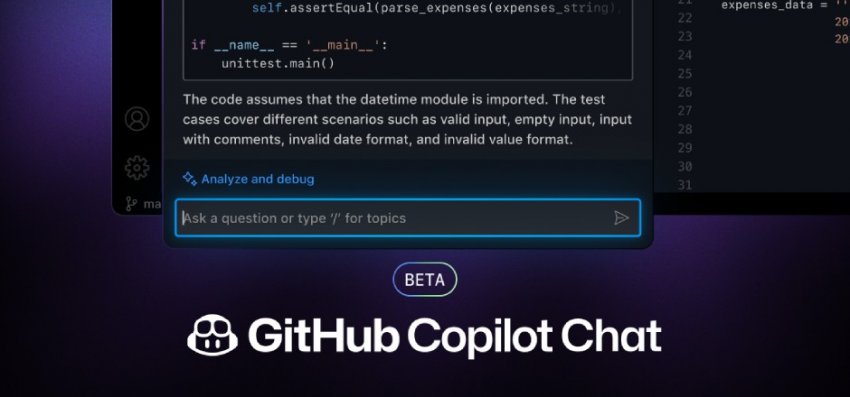

Компания NVIDIA представила бета-версию Chat with RTX – приложение позволяет запускать чат-бота на основе большой языковой модели (LLM) прямо на персональном компьютере. Бот может генерировать релевантные ответы на основе видео и документации юзера. Для работы требуется от 16 Гб оперативки, видеокарта GeForce RTX 30 или 40, а также операционная система Windows 11.

Chat with RTX способен анализировать видео из YouTube – для этого пользователю достаточно ввести адрес страницы ролика, после чего можно получить краткое описание ролика или задавать вопросы по видео. Также ИИ учитывает заметки, документы, данные из файлов, путь к которым укажет юзер. После ответа нейросеть пропишет название файла, который послужил основой для генерации, – это удобно для проверки результата.

Первые тесты показали, что Chat with RTX работает более оперативно, чем ChatGPT и Copilot. В частности, он быстрее обрабатывает большие объемы информации – как из видео, так и из PDF.

В The Verge отмечают, что нейросеть работает с Mistral и Llama – во всяком случае, именно это было показано в демонстрационном ролике. Установка бота на Intel Core i9-14900K с видео картой RTX 4090 занимает порядка получаса. На диске нужно свободных 40 Гб. Пользоваться Chat with RTX можно через веб-интерфейс.

Иногда приложение дает сбои – к примеру, порой берет неправильный ролик из YouTube или вылетает при попытке анализа одновременно нескольких тысяч файлов. Еще один момент – во всех папках, которые индексирует приложение, оно создает файл JSON. После тестирования ранней версии NVIDIA обещает исправить ошибки.